파주안개감시측정소에서 CCTV로 관측된 도로 안개의 강도 측정

Abstract

An effective method for preventing fog accidents is a preliminary measure that promptly communicates the level of fog to the driver, and objective judgment criteria need to be established to set up effective precautionary measures. In this study, a CCTV camera was installed at the Paju Fog Monitoring site to capture images of fog occurring on the road. The analyzed images were divided into two parts of the near-field and the far-field section by improving the existing research methodology. And the accuracy of the image visual range (IVR) was improved by applying the two image visual range functions. Based on the measured actual distances on the road according to the criteria for determining the level of fog crisis by the Ministry of Land, Infrastructure and Transport, the fog was classified into four stages of interest, caution, warning, and seriousness. Of the three fog cases that occurred during the intensive monitoring period, the second fog case was the darkest fog that reached the warning stage, the first fog case had an intermittent caution stage, and the third fog indicated the stage of interest. In some images, The road fog detector developed in this study made a misdetection due to a driving vehicle, and the average misdetection rate was calculated to be 9.9%. It was revealed that the lower the fog intensity, the lower the misdetection rate of the road fog detector, and the higher the fog crisis level, the higher the accuracy of the measurement. As a result of comparative analysis with MOR data of light scattering method at the Paju weather station, a significant difference was found between the MOR and the IVR, so it is necessary to apply IVR using CCTV images rather than MOR in order to provide more accurate information about the crisis level of road fog at the Paju Fog Monitoring site.

Keywords:

Fog, Intensity, Visual range, Image Analysis1. 서 론

사람의 눈은 짙은 안개 속에서 물체의 움직임을 확인하기 어렵다. 자동차에 탑승하여 주행 중인 운전자는 시거가 짧아진 안개로 인해 위기감을 느낄 수 있으며, 공간 이동에 따른 안개 강도의 변화를 체감하게 된다. 특히, 안개 발생 도로 구간 또는 안개 강도 변화 구간에서는 운전자가 안개로 인한 급격한 주행속도 변화에 적절히 대응하지 못하여 차량 추돌 등으로 인한 인명과 차량의 피해가 초래된 바 있다. 2006년 10월 서해대교 29중 추돌사고와 2015년 2월 영종대교 106중 연쇄 추돌사고 사례가 대표적으로서 전국의 도로, 교량 곳곳에서도 안개로 인한 추돌사고가 발생해 왔다 (Lee and Jeong, 2012; Lee et al., 2008). 정부는 안개 등의 기상재해로 인한 피해를 신속하게 대처하기 위해 안개 다발 지역을 지정하고 중계상황실을 운영하며 교통사고 현장의 질서유지 및 사후 안전조치의 업무를 수행하고 있다.

안개 사고 예방을 위한 효과적인 방안은 운전자에게 안개 수준을 신속하게 전달하는 사전 조치이며, 실효성 있는 사전 조치 방안의 수립을 위해 객관적인 판단 기준의 마련이 필요하다. 안개는 수평시정이 1 km 미만인 대기 상태로 기상청의 시정 관측자료가 안개 발생의 유무 확인에 활용되고 있다. 국토교통부는 도로상에서 안개 강도를 위기수준에 따라 분류하여 차량의 주행속도 제한 등의 정보를 가변정보표지판 (variable message sign: VMS)에 제공하고 있다. 그럼에도 불구하고, 안개로 인한 차량 추돌사고를 효과적으로 예방할 방안은 요원한 상황이다. 운전자에게 필요한 실효적인 안개 강도의 정보는 안개 발생 도로 구간의 시정거리이므로 안개 발생 도로 구간에서 시정거리를 측정할 수 있는 방안 마련이 필요한 것이다.

현재 안개 발생에 대한 예보 또는 특보 자료는 시정계 또는 목측에 의한 방법으로 측정장치가 설치된 관측소에서 측정된다. 시정계는 입자상 물질의 광산란량을 계측하여 시정거리를 산출하는 전방산란 방식 시정계 (forward scattering meter)가 주로 사용되는데, 일반적으로 시정계는 외부환경의 영향을 피하기 위해 도로상에 설치되는 경우가 드물고, 주로 기상청의 유인 또는 무인 관측소의 노장에 위치한다 (Kim et al., 2020). 도로상에 설치할 경우, 주행 차량에 의한 입자상 물질의 비산으로 인해 광산란량이 과대 측정될 수 있으며, 강우 시 그 영향이 커서 안개 관측의 신뢰도 저하의 원인이 된다. 또한, 관측소 시정계의 설치 지점이 안개 다발 도로 구간에 근접하지 않기 때문에 측정된 시정거리가 해당 도로의 안개 상황을 제시하는 근거로 활용되는 데에 대표성의 한계가 있다. 따라서 안개로 인한 차량사고 예방 방안을 보다 실질적으로 마련하기 위하여 도로상에서 안개 발생을 관측하고 그 강도를 판별할 수 있어야 한다.

일반적으로 도로 안개는 수백 m에서 수 km 구간에서 발생하고 소멸한다. 도로 구간의 안개는 지형, 대기 조건 등의 영향으로 비균일할 수 있어서 안개 발생지역 내의 도로 구간 이동에 따라 안개의 강도가 변할 수 있다. 따라서, 구간 내의 특정 지점에 설치된 시정계는 해당 도로 구간의 안개 강도 변화를 모두 반영할 수 없는 단점을 지닌다. 이런 문제를 해소하기 위해서는 시정계를 수백 m 간격으로 설치해야 하나, 비용이 만만치가 않다. 국토교통부가 지정한 전국의 안개잦은지역 구간이 약 1,600 km에 이르기 때문이다. 이런 연유로 영상분석이 안개 감지 기술의 비용을 절감하기 위한 새로운 접근 방법으로 대두되었다. 관련 기술은 1대의 영상에서 1 km 내외 도로 구간의 안개 상황을 기록하여 (Hautiére et al., 2006) 측정기 설치비용의 절감과 측정값의 대표성 확보 문제를 해소하기 위한 창의적 접근이었다. 지난 십여 년간 CCTV 등의 영상 매체를 이용하여 시정 또는 안개를 감지하는 연구가 국내·외에서 수행되었다 (Khan and Ahamed, 2020; Kim, 2018; Zhao et al., 2016; Kim, 2015; Chen et al., 2013; Joulan et al., 2011; Liaw et al., 2010; Bäumer et al., 2008; Hautiere et al., 2006) 기존의 영상기반 안개 감지 기술의 초기 단계 연구는 대기 투과도 관점에서 안개 발생 유무만을 판별했으며, 최근 연구는 시정거리 관점에서 안개 발생 유무와 강도를 판별하는 연구로 확대되고 있다. 본 연구에서는 CCTV 영상에서 안개를 객체로 인식하고 객체까지의 거리를 측정하여 안개 강도를 위기수준 단계별로 판별하는 영상분석기술을 적용했다.

2. 관 측

도로상에서 발생하는 안개 영상을 촬영하기 위해 파주안개감시측정소에 CCTV 카메라를 설치했다. 경기도 파주시 적성면 객현리 475-4 인근 일반국도 37번 도로 (북위 37°58ʹ37.78 동경 126°56ʹ33.54 해발고도 33 m)에 위치한 안개감시측정소는 그림 1과 같이 HIKVISION사 모델 DS-2DE5232W-AE CCTV 1대, 자료 저장용 서버 1대, 서버 보호용 하우징으로 구성됐다. CCTV 카메라의 유효화소수는 1920 (H)×1080 (V)으로서 원격제어가 가능하며 야간에는 카메라 스스로 인지하여 IR 필터를 제거하는 자동필터전환 (Infrared Cut filter Removal: ICR) 방식을 사용하여 야간에도 고감도 영상을 제공한다. CCTV 카메라는 지면에서 3.5 m 높이에 설치됐고, 카메라로부터 도로의 직선 구간까지의 거리는 약 1.1 km이며, 이후 곡선 구간이 약 0.8 km에 위치한다. 기타 CCTV 카메라의 제원은 표 1과 같다.

가급적 태양으로 인한 역광 또는 과채도 현상을 방지하기 위해 도로 안개 분석용 표준 영상 화각의 촬영 방향이 설정됐다. 본 연구에서 촬영된 영상의 화각, 도로, 지형 특징을 그림 2에 도식했다. 촬영 영상에서 도로 및 지형의 특징은 직선 도로의 말단에 곡선 도로 구간이 연장되는 형상으로 좌측에는 언덕이, 우측에는 감악산이 위치한다. 그림 1에 나타낸 위성지도 상의 거리는 위·경도를 기준으로 구글어스 (Google earth) GPS 관측 데이터로 산출했다.

안개 강도 변화에 대한 위기수준별 단계는 관심, 주의, 경계, 심각의 4단계로 나누고, 각각 250 m 이상 1,000 m 미만, 100 m 이상 250 m 미만, 50 m 이상 100 m 미만, 50 m 미만으로 구분했다. 관심 단계는 안개 발생 유무를 확인하는 수준으로서 도로를 주행하는 운전자가 안개 발생을 인지할 수 있는 정도의 안개 강도로 본다. 안개 위기수준 관심 단계가 주의 단계에 이르면 운전자는 안개로 인한 전방주시의 필요성이 높아진다. 국토교통부는 주의 단계의 주행속도를 제한속도의 20% 감속으로 지정했다. 경계 단계는 위험을 인지할 수 있는 단계로서 운전자는 주행속도를 제한속도의 50%까지 낮추어야 한다. 심각 단계는 전방 시거 확보가 매우 어려워서 차량사고가 발생할 가능성이 높은 안개 수준이다. 국토교통부가 지정한 안개 위기수준 단계별 특징을 표 2에 요약했다. 국토교통부에서 정의한 안개는 시정거리가 1 km 미만인 조건으로 기상청의 기준과 동일하며, 수평거리가 1 km 이상인 박무 또는 연무와 구분된다. 다만, 국토교통부에서는 4단계로 안개의 강도를 구분하지만, 기상청에서는 3단계로 구분하여 시정거리가 500 m 이상 1000 m 미만, 200 m 이상 500 m 미만, 200 m 미만일 때를 각각 강도 0, 강도 1, 강도 2로 나타낸다.

운전자가 바라보는 시정거리는 3차원 공간의 거리가 2차원 평면 이미지의 거리로 표현된 결과이다. 따라서, 2차원 평면을 X와 Y축으로 하여 픽셀에 대해 위치를 지정하면 이미지에서 보이는 물체까지의 거리를 파악할 수 있다. 본 연구에서는 평면 이미지에 위기수준 단계별 거리를 나타내기 위해 실거리 측정을 시행했다. 실거리 측정은 1 cm 눈금 간격 줄자를 사용했으며, 카메라로부터 10, 50, 100, 250, 1,000 m 지점의 위치를 현장에서 확인하고, CCTV로 촬영된 영상 이미지에 그 위치를 그림 3과 같이 나타냈다. 그림 3의 기준 영상 이미지는 집중관측 이전 맑은 날인 2019년 11월 25일 오전에 촬영됐다.

그림 2에 나타낸 2차원 지도를 살펴보면, 위기수준 단계 중 관심 단계의 거리 범위가 가장 넓지만, 그림 3과 같이 전방을 주시하는 운전자가 바라보는 화각의 영상 이미지에서 관심 단계의 거리는 오히려 상대적으로 좁다. CCTV 카메라가 촬영한 영상 이미지의 실측 거리는 원거리일수록 거리 간 픽셀 수가 감소하며, 실측 거리의 간격이 좁아진다. 그림 3과 같이 이미지 하단으로부터 심각 단계인 약 50 m 부근까지의 픽셀 범위가 가장 넓으며 경계, 주의, 관심 단계로 이동할수록 픽셀의 범위가 좁아지는 현상이 나타난다. 이것은 영상 이미지의 원근감에 의한 현상으로서 원근은 이미지를 바라보는 관찰자까지의 거리뿐만 아니라 이미지에서 물체 간의 깊이감 또는 공간적 관계를 포함한다 (Todorović, 2019). 일반적인 전경 이미지에서는 아래에서 위로 갈수록 거리가 멀어지고, 이미지의 픽셀과 거리는 비선형 관계를 나타내어 위로 갈수록 거리는 기하급수적으로 증가한다. 따라서 안개 강도 변화에 대한 위기수준별 단계를 정량하기 위해서 이미지에 대한 표준 크기 및 픽셀 간격의 설정과 픽셀 및 거리 간 상관함수의 결정이 필요하다.

3. 결과 및 고찰

3. 1 이미지 시정거리 함수 개선

본 연구에서는 Kim (2015)이 제안한 식 (1)을 준용했다. 분석 대상 표준 이미지에 좌표를 부여하기 위해 X와 Y축을 설정하고 각 축의 최댓값은 Kim이 제시한 조건과 동일하게 표준화할 수 있도록 각각 150과 100으로 설정했다. 이미지에서 원거리의 Y값의 변동이 거리에 미치는 영향이 X값에 비해 상대적으로 민감하므로, 거리 변화를 상세하게 관찰하기 위해 분석 대상 표준 이미지의 X, Y값의 간격을 각각 1 및 0.1로 설정하여 X축은 150으로 등분하고 Y축은 1000으로 등분했다.

| (1) |

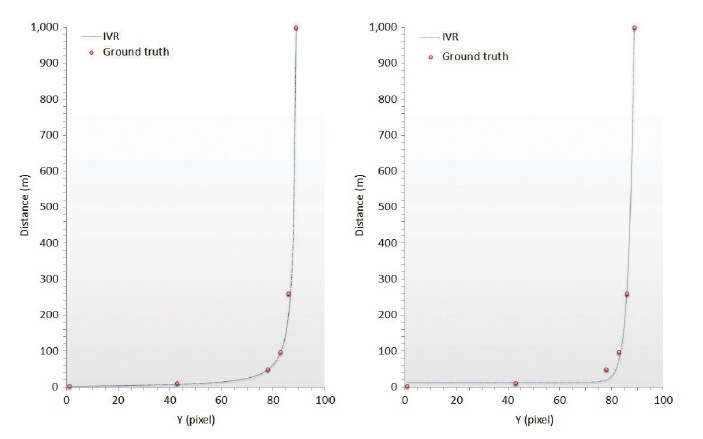

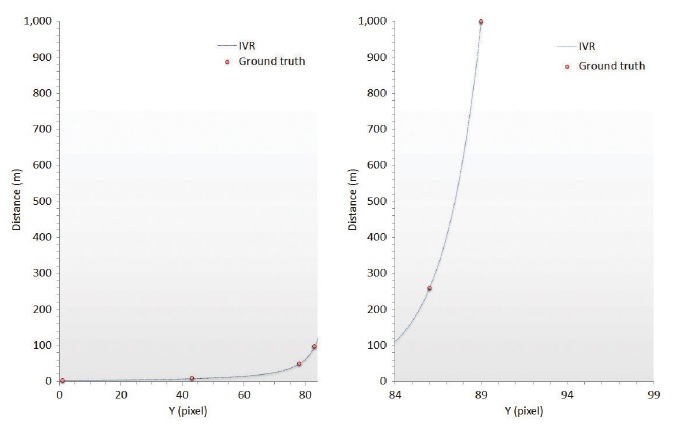

이미지 시정거리 (image visual range: IVR)는 분석 대상 이미지에서 안개로 인해 희미하게 보이게 된 위치의 Y축 픽셀에 해당하는 거리를 의미한다. Kim (2015)에 따르면, IVR은 이미지에서 확인할 수 있는 최장거리 물체의 Y (ymax) 값과 그 거리 (dmax)에 대해 이미지 시정거리효율 (image visual range efficiency coefficient: α)과 비선형보정인자 (nonlinear correcting factor: β)의 함수로서 분석 대상 이미지의 최단거리 (d0)를 고려하여 산출한다. 이미지의 하단부는 Y값이 증가함에 따라 거리가 원만하게 상승한다. 이를 반영하기 위한 인자가 α이며, β는 이미지의 상단부에서 Y값 증가에 따른 거리의 급격한 증가를 반영하는 인자이다. 그림 3에 나타낸 거리에 대한 실측자료 (ground truth: G) 정보를 토대로 IVR의 함수를 결정했으며, 결정된 함수의 설정요소를 표 3에 요약했다. 영상기반 IVR을 기상청의 목측 시정거리 및 기상광학거리 (meteorological optical range: MOR)와 비교 분석한 연구결과에서 IVR은 MOR보다 목측 시정거리와 더 유사하며, IVR 측정에 소폭의 불확실성이 상존한 것으로 보고했다 (Kim, 2018). 본 연구는 측정의 정확도를 제고하기 위해 Kim (2015)이 제시한 연구방법론을 개선하여 인지 가능한 Y값 구간을 2분할함으로써 총 2종의 상관함수를 도출했다. 분할점은 그림 4와 같이 단위 픽셀당 시정거리가 원만한 상승과 급격한 상승을 적절히 반영할 수 있는 지점으로 84로 설정했다. α, β의 값은 서로 연계되어 IVR을 결정하므로, α, β의 값이 바뀌더라도 시정거리의 원만한 상승과 급격한 상승을 동시에 나타내는 데에 한계가 있다. 도로의 기울기, 좌우 상하 굴곡, CCTV의 위치가 α, β의 값에 영향을 미치는데, 본 연구에서는 이미지의 상단부에서 시정거리의 급격한 상승을 실측값에 가깝게 적용하기 위해 두 개의 함수를 적용했다. 84 미만 Y 구간에 적용한 표 3의 제1구간 함수가 84 이상에 적용했을 때 실측값에 대한 오차가 커지므로 본 연구에서는 시정거리가 원만한 상승과 급격한 상승을 적절히 반영할 수 있는 지점으로 84를 설정하고, 84 이상 Y 구간에 표 3의 제2구간 함수를 적용했다. 그 결과 그림 4에서 10, 50, 100, 250 m 실측 거리에 대한 IVR의 평균 절대오차는 4.4%를 나타냈다. 반면에 구간을 분할하지 않고 제1구간과 제2구간의 각 인자를 적용한 결과는 그림 5와 같이 Y 구간을 2분할하여 비교한 결과보다 좋지 않았다. 제1구간의 각 인자를 적용한 결과, 250 m의 실측 거리에서 발생한 큰 오차로 인해 10∼250 m 실측 거리에 대한 IVR의 평균 절대오차가 8.7% (16.5 m)로 증가했다. 이러한 경향이 250 m 초과 범위에서 더욱 뚜렷해져 IVR의 정확도가 더 낮아진다. 제2구간의 각 인자를 적용한 결과에서는 100 m 이하 실측 거리에서 IVR 간 상관성이 낮아져 평균 절대오차가 83.9%로 급증했다. 제2구간의 결과에서 최단거리에 대한 IVR의 절대오차가 평균값에 지배적으로 영향을 미침에 따라, 최단거리를 배제한 50, 100, 250 m에 대한 평균 절대오차는 29.4%로 산출됐다. 결과적으로, 표 3과 같이 제1구간에 적용한 인자로 산출된 IVR은 100 m 이상 장거리 측정에서 오차가 발생하고, 제2구간에 적용한 인자로 산출된 IVR은 250 m 이하 단거리 측정에서 오차가 컸다. 따라서, 제1구간의 인자를 사용해 단거리 구간을 측정하고, 제2구간 인자를 적용해 장거리 구간을 측정함으로써 본 연구를 통해 IVR의 정확도를 개선했다.

Setting parameters for the two IVR functions in this study. The IVR corresponding to the Y values are divided into 2 sections at Y=84.

Relationship between image visual range (IVR) and ground truth in this study. The IVR and the ground truth corresponding to the Y values are divided into 2 sections at Y=84.

3. 2 안개 감지

본 연구에서는 개선된 이미지 시정거리 함수를 이용하여 파주안개감시측정소에서 촬영된 안개 영상 이미지에 대해 CCTV 카메라로부터 안개 영역까지의 거리가 측정됐다. 분석 대상 이미지에서 거리 측정이 완료되면, 다음 분석 단계에서는 이미지 내에 표출된 안개의 위치를 감지한다. 일반적으로 안개는 대기 중에서 입자상 물질에 의한 광산란 현상으로 인해 태양광의 전파장을 산란시킨 색상인 흰색으로 발현된다. 그러나 일출 이전 새벽에 발생한 안개는 태양 광원이 상대적으로 약해서 회색을 띠며, 일시적으로 일출 직후 일부 지역에서는 태양광의 가시광선 파장 특성에 의해 파장이 상대적으로 긴 붉은 색상이 안개의 흰색과 혼합되어 나타나기도 한다. 본 연구에서는 안개의 영역을 표출하기 위해 Kim (2018)이 제시한 패턴 인식 기법을 사용했다. 파주안개감시측정소에서 촬영된 영상 이미지에서 안개의 패턴 영역을 유사 색상을 연결하는 플러드필 (flood fill) 방법으로 화면에 표출했다. 분석 대상 이미지에서 감지된 안개의 영역은 그림 6과 같이 파란색으로 표출된다. 본 연구에서 개발된 도로 안개감지기 소프트웨어 프로그램의 시작화면과 분석결과 예시를 그림 6에 나타냈다. 이미지 분석이 수행되면 색정보의 패턴인식을 이용하여 도로상에서 안개 영역이 표출되고, 측정된 시정거리 (visual range: VR)가 그림 6의 오른쪽 그림과 같이 분석결과의 하단부에 표시된다. VR은 분석 대상 이미지에서 안개 영역의 Y 픽셀값을 토대로 이미지 시정거리 함수에 의해 산출된다. 도로 안개감지기 프로그램은 이미지 시정거리를 VR로 표시한다.

Display result (right) of a fog detection area on the road by the fog pattern recognition method using the Fog Detector software program.

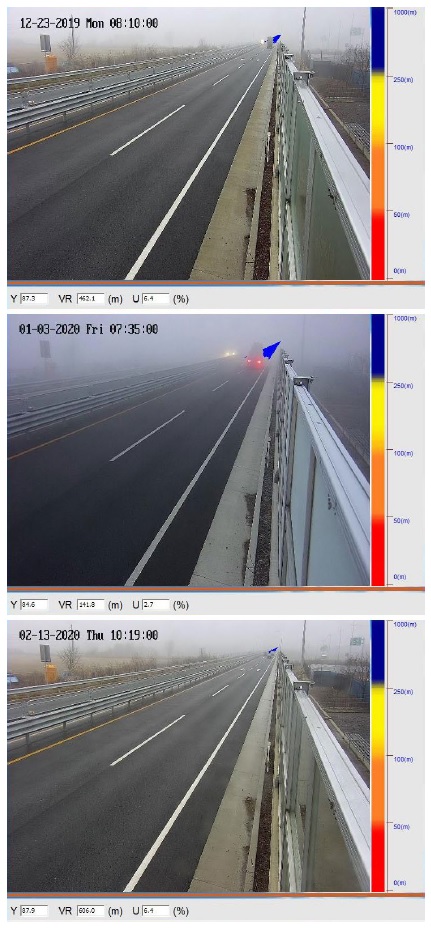

본 연구에서는 파주안개감시측정소에 설치된 CCTV로 안개를 감지하기 위해 표 3과 같이 Y 구간을 2분할하여 적용한 이미지 시정거리 함수가 도입됐다. 2019년 12월 18일부터 2020년 3월 17일까지 약 3개월 수행된 집중관측 기간 중 안개는 1차 (2019년 12월 23일), 2차 (2020년 1월 3일) 및 3차 (2월 13일)에 걸쳐 발생했다. 2019년 12월 23일 오전 8시 3분에서 9시 2분까지, 2020년 1월 3일 오전 7시 34분에서 8시 33분까지, 2월 13일 오전 10시부터 11시 10분까지 촬영된 CCTV 영상에 대해 이미지 분석이 각각 실시됐다. 발생한 안개 사례의 동영상으로부터 안개의 패턴을 분석하기 위해 색정보가 추출됐다. 색정보는 분석 대상 이미지의 150×1000 픽셀에 대한 RGB 값으로서 R, G, B 각 값의 범위는 0~255로 설정된다. 안개의 패턴은 분석 대상 이미지에서 발생된 안개의 색정보 픽셀의 RGB 값으로 결정했으며, 추출된 색정보를 플러드필 기법을 적용하여 안개의 패턴을 영역으로 나타냈다. 최장거리 Y값의 RGB 값을 기준으로 안개의 색상 범위를 플러드필 기법을 활용하여 파란색으로 나타낸다. 색상 범위에 따라 안개 영역이 과대 또는 과소 표출되는데, 본 연구에서 적용한 색상 범위는 20이었다. 도로 안개감지기는 1분 간격으로 이미지 시정거리를 측정하고 그 결과를 화면에 표출한다. 집중관측 기간 중 분석 대상 이미지에 대한 오감지 현상이 발생한 사례를 그림 7에 나타냈다. 주로 발생된 오감지 사례는 도로 안개감지기 프로그램이 감지하는 매분 정각에 안개 패턴 영역에 도로를 주행하는 차량이 위치하여 안개를 분산시키며 안개 패턴 영역을 전반적으로 축소하는 경우이다. 안개 영역의 전반적 축소는 이미지 시정거리를 급격히 증가시켜 불확실성을 유발했다. 오감지된 측정자료는 표 4와 같이 1차 안개 발생 시 총 60개 중 15.0%, 2차, 3차 안개 발생 사례에서는 각각 6.7 및 8.5%를 나타냈다. 집중관측 기간 안개 발생 동영상 분석에서 도로 안개감지기의 평균 오감지율은 9.9%로 산출됐으며, 표 5와 같이 시정거리가 짧을수록 오감지율이 작았다. 이런 현상은 파란색으로 표출된 안개 패턴의 영역에서 주행 차량에 의해 사라진 면적이 그림 7과 같이 시정거리가 짧을수록 상대적으로 작아지기 때문이다. 즉, 근거리의 주행 차량은 안개 패턴 영역 분석에 큰 영향을 미치지 않아서 표 5와 같이 2차 안개 사례에서 오감지율이 가장 낮았다.

3. 3 비교 분석

CCTV로 촬영된 이미지로부터 측정된 이미지 시정거리와 광학적 방식으로 측정된 시정거리 간의 상관관계를 조사하기 위해 경기도 파주시 문산읍 운천리 소재 기상청 파주기상대에서 측정한 기상광학거리 자료가 활용됐다. 파주기상대는 파주안개감시측정소로부터 남서쪽에 위치하고 있으며 파주안개감시측정소와 유사하게 임진강에 근접해 있어서 안개 발생이 잦은 지형적 특징을 나타낸다. 광산란방식 MOR은 OSI사 모델 OWI-430 시정현천계에 의해 1분 간격으로 측정됐다. MOR은 대기 중에서 빛이 도달한 거리를 사람이 바라볼 수 있는 거리로 환산한 개념으로서 계기로 측정할 수 있으나, 계기관측이 모든 측정범위에 걸쳐 적합하지는 않아서 실제 사람이 보는 거리와 상이할 수 있는 것으로 알려져 있다. 반면에, 파주안개감시측정소에 설치된 CCTV 영상은 사람이 눈으로 보는 진짜 색상 (true color)에 가까워서 실제 시정거리에 가깝다고 할 수 있다. 따라서, 집중관측 기간 중 파주안개감시측정소에서 측정된 IVR과 파주기상대에서 측정된 MOR 간의 상관관계를 비교하여 도로에서 발생된 안개 수준 정보를 운전자에게 보다 정확히 전달하기에 적절한 방법에 대해 검토했다.

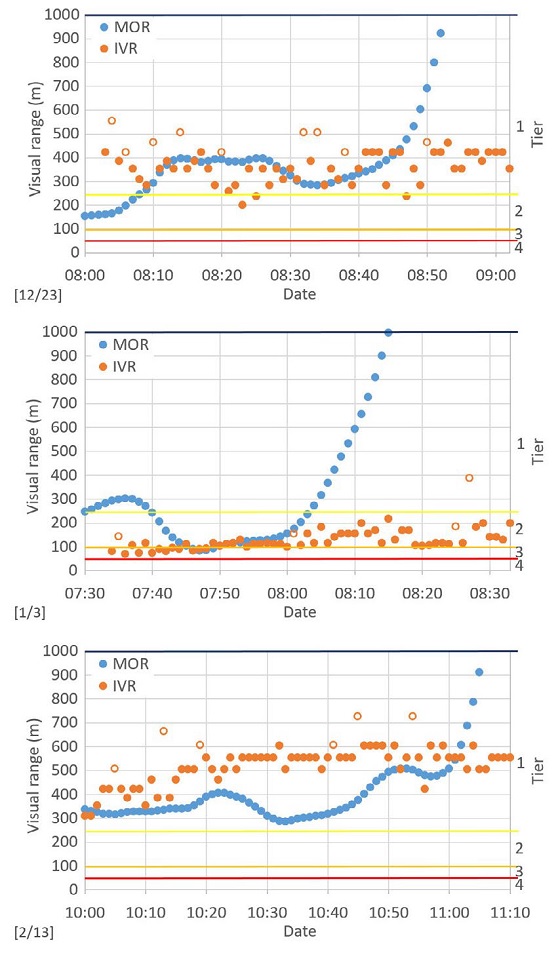

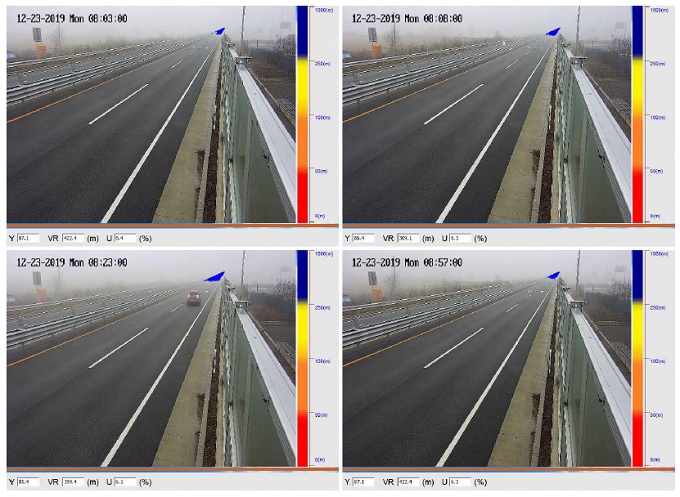

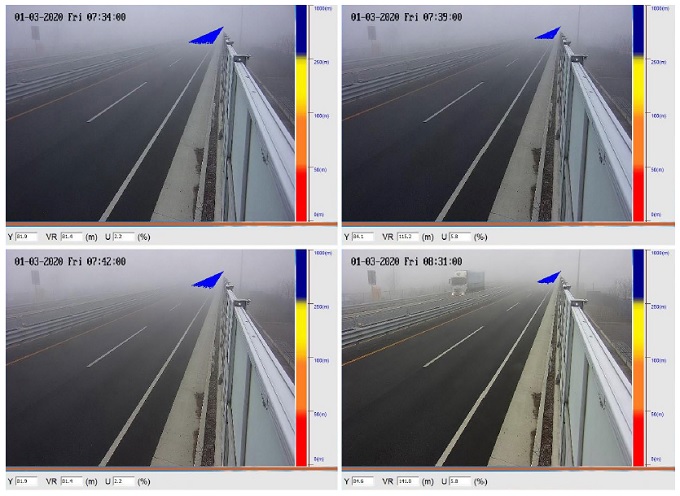

집중관측 기간 중 3회 발생한 안개 사례에 대해 파주도로안개감시측정소에서 측정된 IVR과 파주기상대에 측정된 MOR을 그림 8에 도식했다. 1분 간격 시정거리 자료는 안개 위기수준 단계 (tier)별로 1단계 (관심), 2단계 (주의), 3단계 (경계) 및 4단계 (심각)로 구분해서 표시했다. IVR의 자료 중 빈 원으로 표시된 값은 주행 중인 자동차에 의해 오감지된 측정값을 나타낸다. 2019년 12월 23일 발생된 1차 안개 사례에서 MOR은 오전 8시에 154 m에서 8시 52분에 923 m까지 증가하여 53분에 소멸했다. 그러나 IVR은 8시 3분에 422 m로 시작하여 199 m에서 461 m 범위에서 변동을 나타냈고, 9시 2분에는 353 m를 나타내어 MOR과 IVR 간 안개 위기수준 단계의 변화가 일부 상이했다. IVR과 MOR은 8시 3분에서 8분까지 뚜렷한 차이를 나타냈다. MOR은 2단계인 주의 단계에 해당하는 시정거리를 나타냈지만 IVR은 1단계인 관심 단계에 해당하는 시정거리를 나타냈다. 실제 CCTV 영상의 당시 시정거리는 그림 9와 같이 1단계로 보인다. 또한, 8시 23분과 25분에는 MOR이 1단계를 나타냈지만, IVR은 2단계를 나타냈고, 실제 영상은 그림 9와 같이 2단계에 해당했다. 그림 9의 이미지 내의 실측 거리는 그림 3으로 판단할 수 있으며, 영상의 촬영 시각은 각 그림의 상단 좌측에 표시되어 있다. 2020년 1월 3일 발생한 2차 안개는 1차 안개보다 짙었다. MOR은 오전 7시 34분에서 44분까지 IVR보다 안개 위기수준 단계가 2단계 이상으로 높았으나, 실제 영상은 그림 10과 같이 2단계인 주의 또는 3단계인 경계 단계에 해당했다. MOR로 안개 위기수준 단계를 적용 시 잘못된 정보가 운전자에게 전달될 수 있음이 확인됐다. MOR은 오전 8시 4분 이후 급격히 상승했고, 안개는 8시 15분 이후에 소멸한 것으로 나타났다. 그러나 IVR의 변화를 살펴보면, 8시 4분 이후 8시 33분까지 2단계 안개 수준인 주의 단계를 유지했다. 그림 10에서 8시 31분의 IVR 분석결과와 실제 안개 수준을 확인할 수 있다. 2020년 2월 13일의 3차 안개 사례는 집중관측 기간 중 가장 옅었다. MOR에 따르면 안개는 11시 5분 이후에 소멸했으나, IVR은 11시 10분까지 353 m에서 606 m 범위에서 변동하며 소멸하지 않았다. 3차 안개 사례에서 MOR과 IVR 간의 안개 위기수준 단계는 1단계인 관심 단계로 대체로 유사했지만, 11시 5분 이후에 MOR과 IVR 간 차이가 발생했다.

The visual range and the tier measured by MOR and IVR. The IVR marked with a hollow circle is the data that was detected incorrectly by driving cars.

The image analytic results of the inconsistent Tiers between MOR and IVR for the first fog event during the monitoring period.

The image analytic results of the inconsistent Tiers between MOR and IVR for the second fog event during the monitoring period.

집중관측 기간 중 파주지역에서 발생한 3회 안개 사례에 대해 오감지 자료를 제외하여 분석결과, 1차 안개 사례에서 IVR과 MOR의 평균값은 각각 354±62 m와 579±429 m을 나타냈으며, 2차 안개 사례에서는 각각 124±35 m와 913±1110 m을 나타냈고, 3차 안개 사례에서는 각각 514±75 m와 478±304 m을 나타냈다. IVR은 3회 모두 편차가 상대적으로 작아서 안개 강도의 변화가 크지 않았지만, MOR의 편차는 IVR보다 커서 안개 강도의 변화가 상대적으로 컸다. 이런 현상은 2차 안개 사례에서 뚜렷하게 나타났으며, 그 원인은 안개의 강도가 약해지며 소멸한 시각이 서로 상이한 데에 있었다. 그림 9와 같이 2차 안개 사례에서는 파주안개감시측정소 8시 31분에도 도로상에서 위기수준 주의 단계의 안개가 확인됐으나, 파주기상대의 MOR 값은 그림 7과 같이 8시 15분 이후에 안개가 소멸한 것으로 기록했다. 1차와 3차 안개 사례 역시 MOR의 안개 소멸시각에 IVR은 안개가 소멸하지 않은 것으로 나타나서 파주기상대의 MOR이 파주안개감시측정소 주변 도로의 안개 상황을 정확하게 반영하는 데에 한계가 있음이 확인됐다. 안개의 지속시간과 강도의 공간적 분포는 안개의 종류에 영향을 받는다 (Mun and Lee, 2013; Yoon and Chung, 1996). 일반적으로 바람이 강하지 않다면 복사안개는 균일한 분포를 나타낸다. 파주에서 3회 발생한 안개는 복사안개이었지만, 파주기상대와 파주안개감시측정소의 공간적 차이로 인해 안개의 소멸시각에 차이가 발생한 것으로 판단된다. 기상청 기상자료개방포털 자료에 따르면, 1, 2, 3차 안개 사례의 파주기상대에서 관측 풍속은 각각 0, 결측, 0.1 m/s를 나타냈으며, 결측 전 오전 4시 풍속이 0 m/s로 측정되어 바람에 의한 영향은 미미했던 것으로 조사됐다.

4. 결 론

본 연구에서는 파주안개감시측정소에서 2019년 12월부터 약 3개월간 안개로 인한 차량사고 예방을 위한 효과적인 방안을 마련하기 위해 도로 안개를 감지하고 그 강도를 판별할 수 있는 영상분석 방법을 사용하여 안개 관측을 실시했다. 본 연구에서 개발된 도로 안개감지기 프로그램은 CCTV 영상 이미지에 개선된 이미지 시정거리 함수를 적용하고 안개의 패턴 영역을 감지하여 시정거리를 측정한다. 시정거리의 정확도를 제고하기 위해 Y값 구간을 2분할한 2종의 상관함수가 적용됐다. 측정된 시정거리를 토대로 국토교통부 안개 위기수준 판별 기준에 따라, 관심, 주의, 경계, 심각 4단계로 안개를 분류하여 분석한 결과, 집중관측 기간 발생한 총 3회의 안개 사례 중 2차 안개 사례가 경계 단계에 다다르는 가장 짙은 안개였고, 1차 안개 사례는 간헐적으로 주의 단계가 있었으며, 3차 안개는 관심단계를 나타냈다. 일부 영상에서 주행 차량에 의해 오감지된 사례가 도로 안개감지기의 오감지를 유발했으며, 평균 오감지율은 9.9%로 산출됐다. 도로 안개감지기의 오감지율은 안개의 강도가 낮을수록 작아서 안개 위기수준이 높아질수록 측정의 정확도가 높았다. 파주기상대의 광산란방식 MOR 자료와 비교분석한 결과, MOR과 IVR 시정거리 간에 적지 않은 차이가 발견되었으며, 안개 위기수준 단계에서도 부분적으로 상이한 결과가 나타났다. 집중관측 기간 중 발생했던 안개는 복사안개이지만 두 지점의 공간적 차이에 의해 안개 강도의 변화와 소멸시각에서 차이가 나타났다. 특히, 2차 안개 사례에서 파주안개감시측정소의 도로에서는 위기수준 주의 단계의 안개가 확인됐으나, 파주기상대의 MOR 값은 안개가 소멸한 것으로 기록한 차이가 발견됐다.

안개 다발 지역의 운전자에게 안개 발생 정보는 안전사고 예방에 중요한 요소이다. 기상청은 파주기상대에서 측정된 MOR 정보로 파주지역의 안개 관측 결과를 제공한다. 당시 안개 위기수준의 정보를 제공하지 않았으나, MOR을 근거로 도로 안개의 위기수준을 판별했다면, 집중관측 기간 중 파주안개감시측정소의 도로를 주행한 차량은 실제와 상이한 정보를 제공받았을 가능성을 배제할 수 없다. 결과적으로 위험기상 발생 시 도로안전 관리 측면에서 안개 다발 지역인 파주에서 발생한 안개의 위기수준 정보를 상세하고 정확하게 전달할 필요성이 있다. 따라서 본 연구의 결과는 파주안개감시측정소에서 발생한 도로 안개의 위기수준 정보를 보다 정확하게 제공하기 위해 MOR보다 CCTV 영상을 이용한 IVR 적용의 필요성을 시사한다.

Acknowledgments

본 논문은 서울기술연구원 과제번호 2021-AD-001 (위기수준 4단계 안개 탐지 및 차량사고 정확도 90% 감지 기술 개발)인 국토교통과학기술진흥원 (과제번호 20CTAP-C152066-02, 고유번호 1615012021)의 지원으로 수행되었으며, 이에 감사드립니다.

References

-

Bäumer, D., Versick, S., Vogel, B. (2008) Determination of the visibility using a digital panorama camera, Atmospheric Environment, 42(11), 2593-2602.

[https://doi.org/10.1016/j.atmosenv.2007.06.024]

- Chen, X., Lu, C., Zhang, Y. (2013) A New Algorithm for Calculating the Daytime Visibility Based on the Color Digital Camera, International Journal of Computer Science Issues, 10(1), 574-579.

-

Hautiére, N., Tarel, J.P., Lavenant, J., Aubert, D. (2006) Automatic fog detection and estimation of visibility distance through use of an onboard camera, Machine Vision and Applications, 17, 8-20.

[https://doi.org/10.1007/s00138-005-0011-1]

-

Joulan, K., Hautiére, N., Brémond, R. (2011) A Unified CSF-based Framework for Edge Detection and Edge Visibility. In: Proceedings of IEEE Conference on Computer Vision and Pattern Recognition Workshops, Colorado Springs, USA, pp. 21-26.

[https://doi.org/10.1109/CVPRW.2011.5981679]

-

Khan, M.N., Ahmed, M.M. (2020) Trajectory-level fog detection based on in-vehicle video camera with TensorFlow deep learning utilizing SHRP2 naturalistic driving data, Accident Analysis & Prevention, 142.

[https://doi.org/10.1016/j.aap.2020.105521]

-

Kim, K.W. (2015) Estimation of visibility using a visual image, Environmental Monitoring and Assessment, 187(3), 66.

[https://doi.org/10.1007/s10661-015-4297-9]

-

Kim, K.W. (2018) The Comparison of Visibility Measurement between Image-Based Visual Range, Human Eye-Based Visual Range, and Meteorological Optical Range, Atmospheric Environment, 190, 74-86.

[https://doi.org/10.1016/j.atmosenv.2018.07.020]

-

Kim, M., Lee, K., Lee, Y.H. (2020) Visibility Data Assimilation and Prediction Using an Observation Network in South Korea. Pure and Applied Geophysics, 177, 1125–1141.

[https://doi.org/10.1007/s00024-019-02288-z]

- Lee, S.I., Won, J.M., Ha, O.K. (2008) A Study on the Development of a Traffic Accident Ratio Model in Foggy Areas, Journal of the Korean Society of Safety, 23(6), 171-177.

-

Lee, S.K., Jeong, J.H. (2012) Estimating the Effectiveness of Fog Detect & Warning System by Driving Simulator, Journal of the Korean Society of Hazard Mitigation, 12(1), 111-117.

[https://doi.org/10.9798/KOSHAM.2012.12.1.111]

-

Liaw, J.J., Lian, S.B., Huang, Y.F., Chen, R.C. (2010) Using sharpness image with Haar function for urban atmospheric visibility measurement, Aerosol and Air Quality Research, 10, 323-330.

[https://doi.org/10.4209/aaqr.2009.11.0074]

-

Mun, S., Lee, S. (2013) A Study on the Change of Fog Frequency and Duration Hours in South Korea, Journal of Climate Research, 8(2), 93-104.

[https://doi.org/10.14383/cri.2013.8.2.93]

-

Todorović, D. (2019) Effects of Changes of Observer Vantage Points on the Perception of Spatial Structure in Perspective Images: Basic Geometric Analysis, Axiomathes.

[https://doi.org/10.1007/s10516-019-09421-6]

- Yoon, M.B., Chung Y.S. (1996) Charateristics of Fog and Mist Observed in the Rural Area of Chongju and Chongwon, Journal of Korea Air Pollution Research Association, 12(1), 15-21.

-

Zhao, J., Han, M., Li, C., Xin, X. (2016) Visibility Video Detection with Dark Channel Prior on Highway, Mathematical Problems in Engineering, Article ID 7638985.

[https://doi.org/10.1155/2016/7638985]

김경원 (서울기술연구원 스마트도시연구실 연구위원)